1. 安装hadoop

安装hadoop集群

1. 安装hadoop

将压缩包复制到/usr目录下

解压 tar -zxvf 压缩包名字 -C /usr

2.修改配置文件

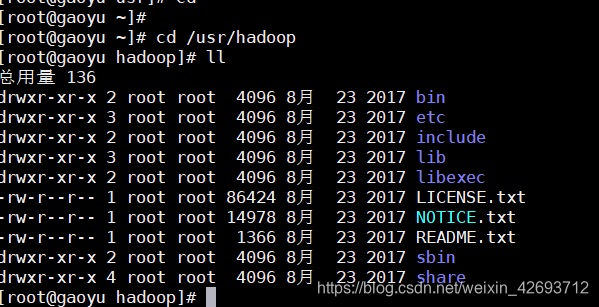

2.1 查看所有文件

2.2 修改hadoop.env.sh

进入/usr/hadoop/etc/hadoop目录下

配置

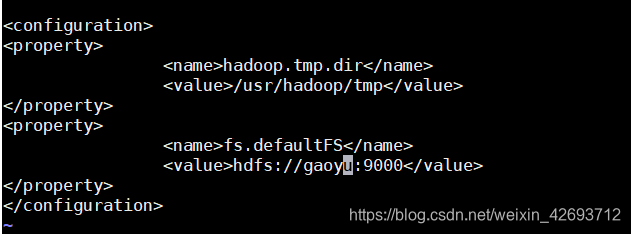

2.3 配置core-site

进入/usr/hadoop/etc/hadoop目录下vi core-site.xml

1 | <property> |

2.4

配置hdfs.site

进入/usr/hadoop/etc/hadoop目录下vi hdfs-site.xml

1 | <property> |

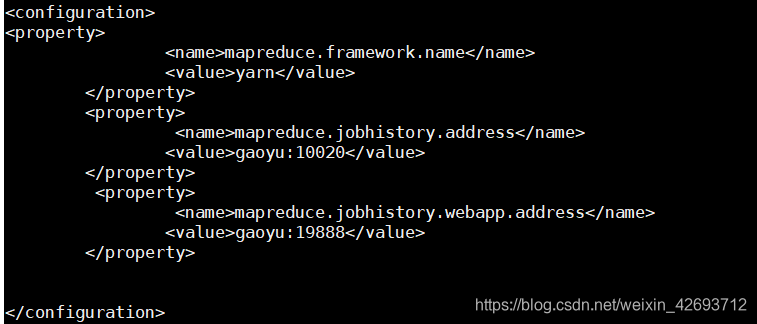

2.5 配置mapred-site.xml

复制模板

进入/usr/hadoop/etc/hadoop目录下mv mapred-site.xml.template mapred-site.xml

修改配置vi mapred-site.xml

2.6 配置yarn-env.sh

进入/usr/hadoop/etc/hadoop目录下vi yarn-env.sh

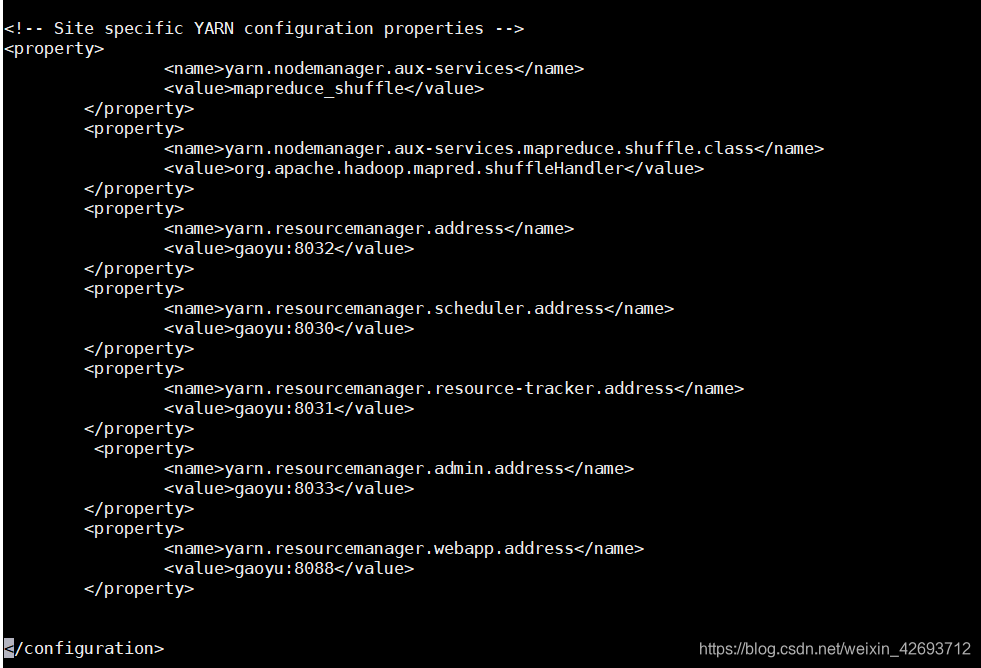

2.7 配置yarn-site.xml

进入/usr/hadoop/etc/hadoop目录下vi yarn-site.xml

2.5 配置slavesvi slaves

2.6 配置hadoop环境变量

进入/usr/hadoop/etc/hadoop目录下vi /etc/profile

1 | #hadoop environment |

刷新:source /etc/profile

3. 复制文件到其他机器

1 | scp -r /usr/hadoop gaoyu1:/usr/ |

1 | scp -r /usr/hadoop gaoyu2:/usr/ |

1 | scp /etc/profile gaoyu1:/etc |

1 | scp /etc/profile gaoyu2:/etc |

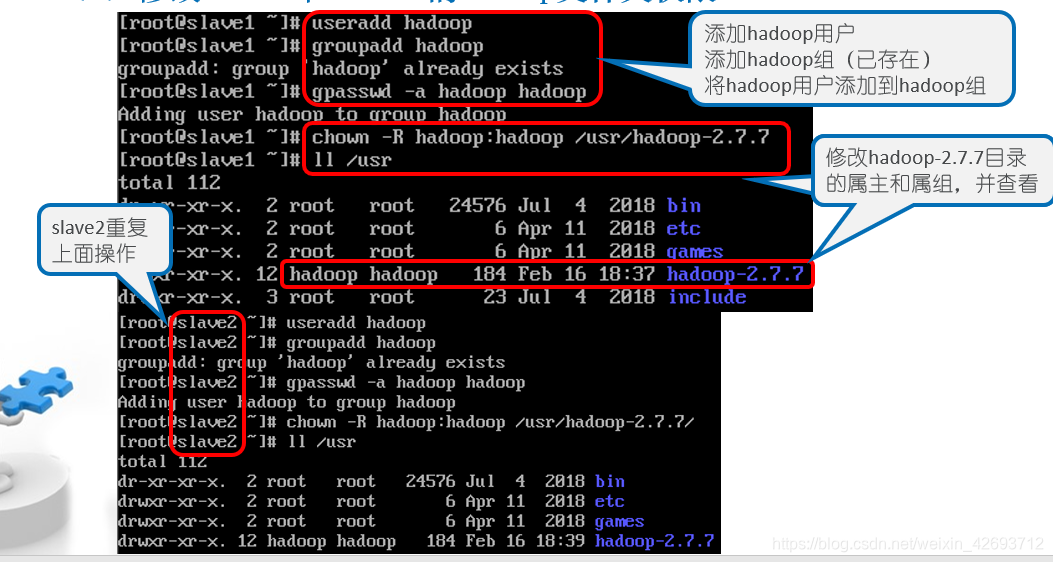

在三台机器上分别操作(root下)

useradd hadoopgroupadd hadoopgpasswd -a hadoop hadoopchown -R hadoop:hadoop /use/hadoopll /usr

其他两台照做一遍

4.格式化hdfs

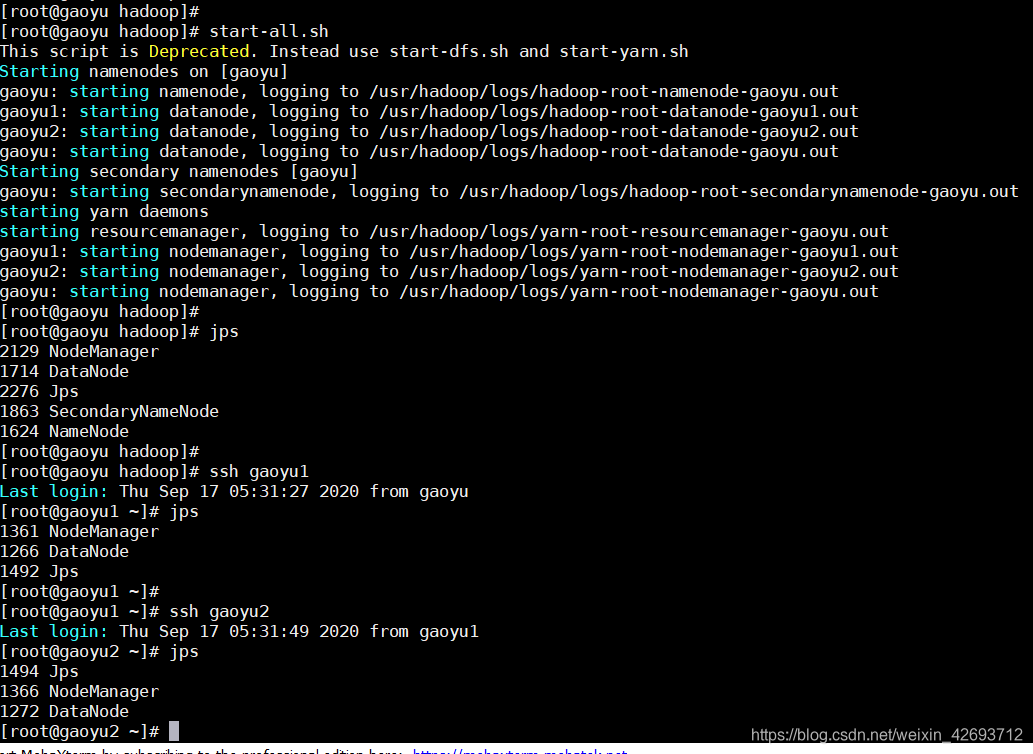

5.启动hdfsstart-all.sh

关闭:stop-all.sh

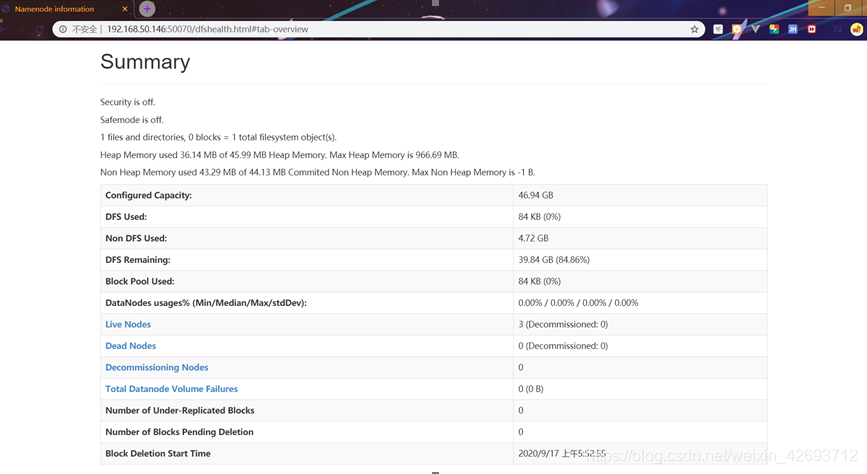

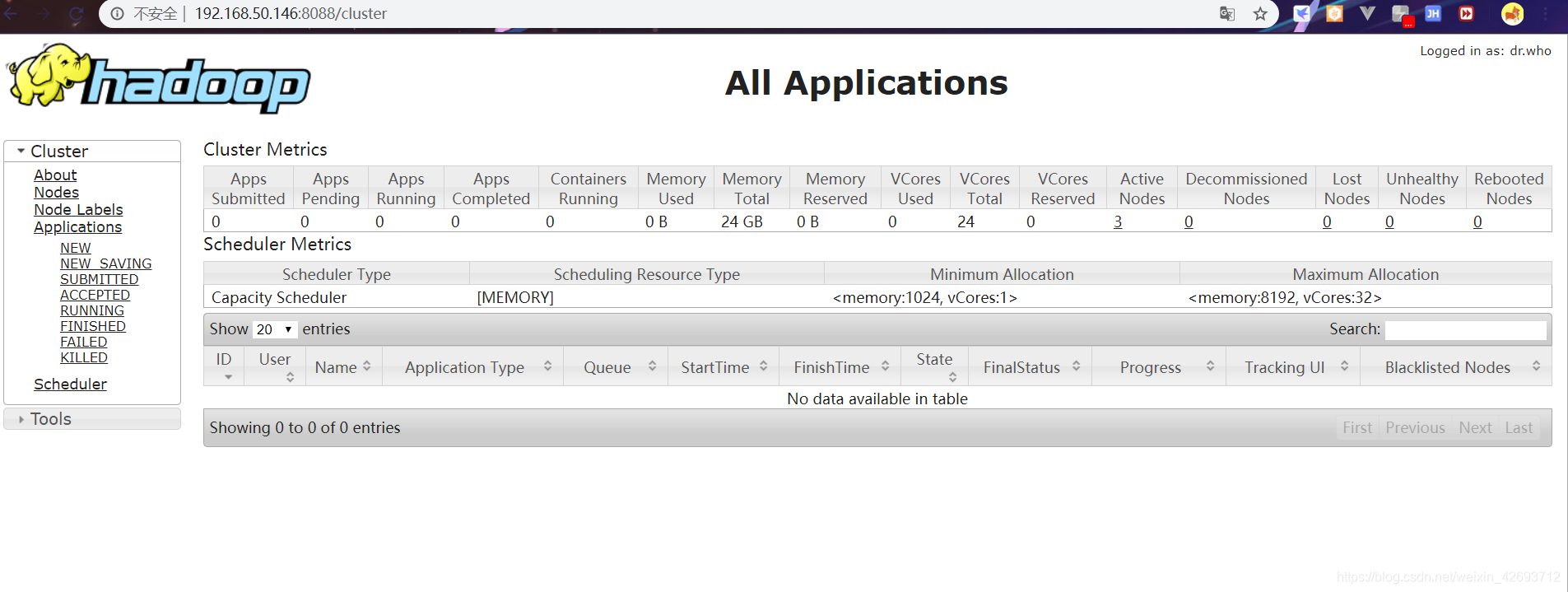

查看: