MapReduce经典案例–数据去重

项目完整代码以及两个test文件以及maven环境所需jar包:

链接:https://pan.baidu.com/s/10MEBxCfy_ShTaCf_RhGzMw

提取码:1314

- 首先要在windows上搭建开发环境 见https://blog.csdn.net/weixin_42693712/article/details/108796708

- 打开本机eclipse,创建一个maven工程

- 选择file->new->maven project创建maven工程,选择create a simple project选项,点击next GroupId写com.itcast,Artifact写HadoopDemo,其他默认就好

- 编辑pom.xml添加依赖,依赖添加成功后,在maven Dependenciens下面自动会有jar包

1 | <project xmlns="http://maven.apache.org/POM/4.0.0" |

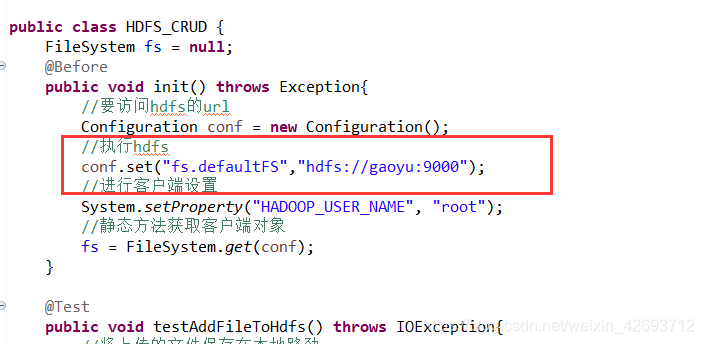

- 在src下建立com.itcast.hdfsdemo包,建立HDFS_CRUD类以初始化客户端对象

1 | package com.itcast.hdfsdemo; |

注意:

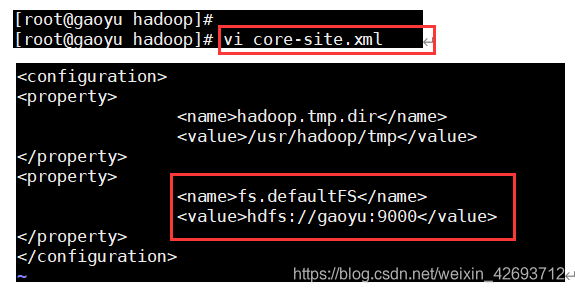

gaoyu:9000s是自己设置的在core-site.xml中,自行查看

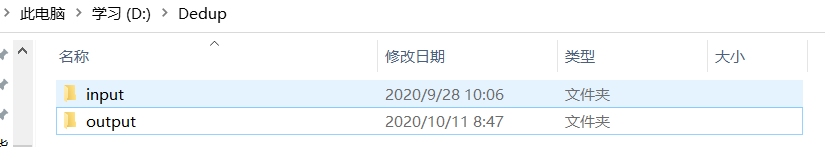

其中output在本地目录下不用创建,会自动生成,input目录需要自行创建在相应路劲下,我的是在D:\Dedup\input目录下,和代码中位置需要一直一致

- 创建cn.itcast.mr.dedup包,在该路径下编写自定义Mapper类DedupMapper,自定义Reducer类DedupReducer以及运行主类DedupDriver

DedupMapper 类

1 | package cn.itcast.mr.dedup; |

DedupReducer类

1 | package cn.itcast.mr.dedup; |

DedupRunner类

1 | package cn.itcast.mr.dedup; |

- 代码编写完毕后,打开虚拟机开启所有服务进程

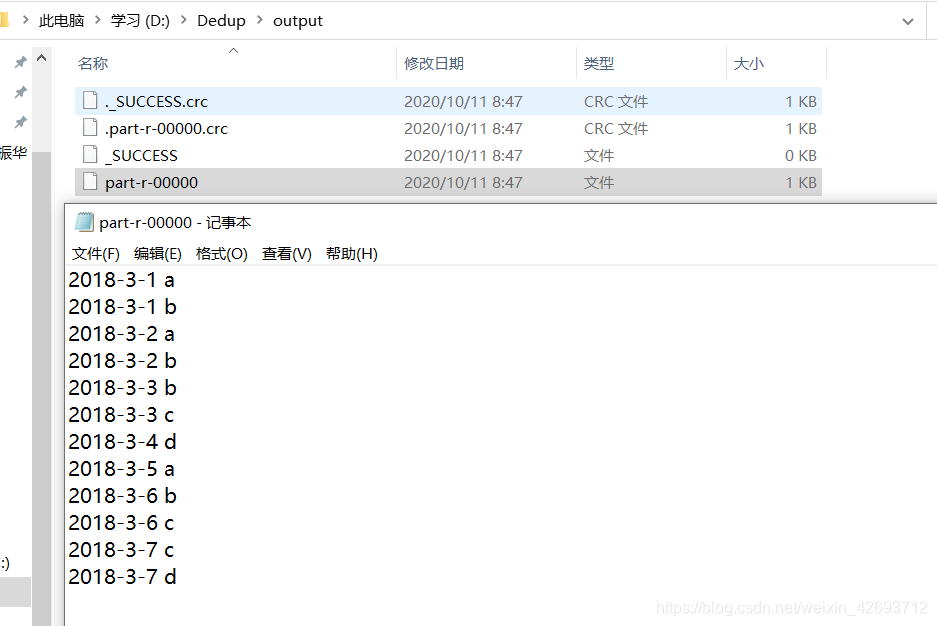

start-all.sh - 然后运行主类DedupRunner,在output目录下查看结果

查看文件part-r-00000发现已经成功